机器人的平权宣言:为什么我们非得被造成白色的?

2018-09-04

用百度搜索“机器人”的图片。

不出意外,结果应该就和文摘菌下面查到的差不多。

仔细看看,有没有觉得哪里不对劲呢?

大多数人应该和文摘菌一样,没看出什么异常。然而,来自新西兰坎特伯雷大学的Christoph Bartneck教授却指出:这样的结果大有问题——为什么机器人就一定要是白色的呢?

在今年的ACM/IEEE人-机器人交互(Human Robot Interaction)国际会议上,来自新西兰坎特伯雷大学人机交互技术实验室的Chrstoph Bartneck教授等人发表了他们关于机器人种族属性的研究。他们发现,人们会将具备拟人化特征的机器人归类于某个种族,导致人类对该种族的偏见会被投射到机器人身上。

“我们希望本研究能够鼓励机器人设计师们创造出代表他们群体多元化特征的机器人,没有必要把所有机器人都设计成白色。”Bartneck如是说。

不少人或许会对这样的研究嗤之以鼻额。毕竟,如果我们询问机器人制造公司,为什么要将他们的机器人设定为白色,他们十有八九会告诉你:因为白色跟各种家庭装饰都很百搭呀!

实际上,Bartneck的文章在投稿期间就收到了不小的阻力。他们的文章被读者反复审视,有些人指责作者在耸人听闻。

那么,这项研究的结论究竟如何得出,对我们又有哪些启发呢?

让我们通过IEEE对Bartneck的一段专访作进一步的了解。

专访内容

《科技纵览》杂志(IEEE Spectrum):你在这项研究中具体在回答什么问题?

Christoph Bartneck:首先,我们想探究人类是否将机器人与种族相关联。其次,如果答案是肯定的,那这种对机器人种族的归类是否影响人类对待这些机器人的行为。更详细地说,我们会让参与者回答一系列问题,包括对某一机器人的种族分类(选项包括“不赋予种族”)另外, 我们也使用了“射手偏见”框架(shooter bias framework)。

在射手偏见研究中,参与者被赋予警察的角色,当面对人们手持枪械或其他友好物体的图像时,他必须决定是否射击。图像仅显示一瞬间,研究中的参与者来不及做出合理的思考,他们必须在不到一秒的时间内采取行动。若参与者在决定开枪时对黑色机器人(对比白色机器人)开枪更加快速,在决定对没有武器的机器人不开枪时对白色机器人(对比黑色机器人)下决定更快速,我们就会认为这位参与者对机器人存在种族偏见。

《科技纵览》杂志(IEEE Spectrum):你们的研究结果如何?

Christoph Bartneck:我们在调查中直接要求人们选择“该机器人是什么种族”时,只有11%的被调查者选择了“不适用”选项。我们的隐性衡量标准证明了人们确实种族化机器人并据此调整他们的行为。我们调查的参与者显示他们存在对机器人的种族偏见。

此外,我们的“射手偏见”研究显示,无论图像中出现的是人类还是机器人,与武装的白人相比,参与者更快地射击武装的黑人;同时更快地避免射击手无寸铁的白人,而不是同样解除武装的黑人。这些发现说明了射手偏见既存在于人类之中,同时也存在于机器人之中。这种偏见明确表现了对黑人的种族歧视,更是将这种歧视自动延伸至种族化为黑人的机器人。

《科技纵览》杂志(IEEE Spectrum):为什么这个主题以前未曾被研究过?你为什么决定对此展开研究?为什么它很重要?

Christoph Bartneck:许多工程师都忙于实现机器人基本功能,如行走与在所处环境中移动。这是他们最为关注的问题,以至于他们没有那么重视研究所产生的社会影响。

大部分时候,机器人的设计是由内而外的,意味着各功能部件先被搭建并测试,最后再添加一个外壳包装。至于这层包装将如何影响人类使用者,或更宽泛地说,机器人整体将如何被其使用者所感知,绝大多数时候只有事后才会被想到。

因此,几乎没有机器人创造者思考过种族歧视问题。多年来,人-机器人交互(HRI)社区的成员们在尝试更深理解人类与机器人是如何交互的。我们试图帮助机器人创造者将机器人设计得与社会更加融合。种族歧视对人类与人类社会整体都正在造成大量伤害。

今天,种族歧视依然真实地存在,黑人平权运动更加证明了这个问题的重要性与紧急性。与此同时,我们将推出社交机器人,目的是与人类互动,融入人类社会。这些机器人将成为未来的护工,教育人员与陪伴者。

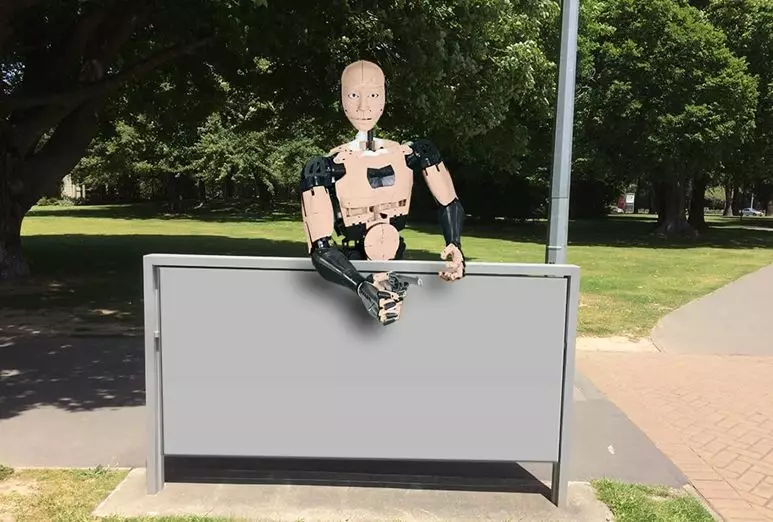

在谷歌图片中搜索“类人机器人”,你几乎只会搜到拥有闪亮白色表面或金属外表的机器人图片。现在几乎没有非白人外表的拟人机器人。大多数主流社交机器人研究平台,如Nao,Pepper与PR2,机器人均使用白色材料,并且看起来是白人。

也有一些特例,比如一些由Hiroshi Ishiguro团队设计的机器人——这些机器人的面部以某些特定的日本人为模型,因此它们的种族为亚洲人(如果机器人真的拥有种族属性的话)。另一个特例是Bina48机器人,它被设计为黑人形象。

可以预见到,这种社交机器人种族多元性的匮乏会导致一系列问题以及其他领域中种族多元性的匮乏。我们根据各社会分类下的社会观念导致的刻板印象去评价他人。比如,歧视经常是社会刻板印象的一种体现。如果机器人将被用于教师,好友或护工并且这些角色都只被白人机器人取代,这将会是一个严重问题。

我们希望我们的研究能促使人类进行反思,是什么社会与历史因素导致了来自如此多元化的种族群体的工程师们几乎只设计生产很容易被当做白人的机器人,他们为何尚未意识到这一点。

《科技纵览》杂志(IEEE Spectrum):如果机器人被认为是分种族的,这将对人-机器人交互(HRI)有何影响?

Christoph Bartneck:我们相信我们的发现将会帮助社交机器人设计上的多元化,这样一来这项前景光明的科技不会受到种族偏见的影响。中东样貌的机器人的出现以及日本惯以设计亚洲人样貌的机器人都是这个方向上的重要进步,尤其是因为这些机器人并非被刻意设计成丰富种族多元化的形象,而是机器人设计上的自然产物。

《科技纵览》杂志(IEEE Spectrum):您能否讨论一下该研究的局限性?您将来如何改进该领域的研究?

Christoph Bartneck:不难推测,不同程度的拟人化可能会导致不同的结果。如果几乎难以区分机器人与人类,那么我们期望得到与原始研究相同的结果,而更机械化的机器人可能具有尚未确定的影响。人们也可以思索一下我们使用的种族化方法。

为了最好地复制原始的射手偏见刺激,我们选择使用人工校准让Nao机器人呈现种族化特征,而不是使用Nao默认的白色塑料外观以及与之相对的黑色材料机器人。

值得注意的是,Nao机器人没有穿任何衣服,这与原始研究中的人类不同。另外很奇怪的是,原始研究中图像里的人们没有影子。借助Adobe Photoshop强大的功能,我们能够在Nao机器人背后投射阴影合成更为逼真的图像。未来的研究应该包括拿着枪和其他物体的Nao机器人,并伴有多种姿势。

我们也将对机器人表面颜色添加渐变色,使其包括几种棕色渐变色。此外,我们正在研究机器人的拟人化程度会如何影响对种族的认知。

《科技纵览》杂志(IEEE Spectrum):听说HRI会议接收该论文的过程并不顺利,您能详细说明吗?

Christoph Bartneck:这篇提交给HRI会议的论文经历了空前的审查过程。论文大约有5000个词,但收到的评论就有大约有6000个词。在会议计划委员会开会期间,大家对文章进行了详细的讨论,共有9名评审员被要求对该研究进行评估。

这篇论文最终被有条件地接收,他们分派一个专门的编辑,与我们一起解决审稿人提出的所有问题。这样子,作者和编辑可以尽其所能解决所有争论并找到合适的答案。论文中的方法和统计数据从未被怀疑,大多数评论者着眼于术语和文字表达。

在会议之前,我联系了会议的主持人,并建议在会议上进行小组讨论,以便就该主题进行公开辩论。不过,最初热情的提议最终被拒绝了。接着,我建议在分配给该项研究的演示时段内留出小组讨论的时间。获得初步同意之后,我寻求了两位同意参加的专家,然而会议组织者禁止了这次小组讨论。在演示的前一天,我被要求在没有任何评论或小组讨论的情况下提交论文。

我们试图在会议上就我们论文的结果进行公开讨论,但都遭到了拒绝。我认为这种拒绝公开讨论会阻碍对该领域的进一步研究。那你为什么要让自己暴露在如此严厉的,意识形态驱动的批评当中?我认为我们需要有一种支持和鼓励的文化来研究有争议的话题。

《科技纵览》杂志(IEEE Spectrum):您希望看到这项研究成果如何应用?

Christoph Bartneck:我们希望这项研究鼓励机器人设计师们创造出代表社区多样性的机器人,不是所有的机器人都得是白色的。

用百度搜索“机器人”的图片。

不出意外,结果应该就和文摘菌下面查到的差不多。

仔细看看,有没有觉得哪里不对劲呢?

大多数人应该和文摘菌一样,没看出什么异常。然而,来自新西兰坎特伯雷大学的Christoph Bartneck教授却指出:这样的结果大有问题——为什么机器人就一定要是白色的呢?

在今年的ACM/IEEE人-机器人交互(Human Robot Interaction)国际会议上,来自新西兰坎特伯雷大学人机交互技术实验室的Chrstoph Bartneck教授等人发表了他们关于机器人种族属性的研究。他们发现,人们会将具备拟人化特征的机器人归类于某个种族,导致人类对该种族的偏见会被投射到机器人身上。

“我们希望本研究能够鼓励机器人设计师们创造出代表他们群体多元化特征的机器人,没有必要把所有机器人都设计成白色。”Bartneck如是说。

不少人或许会对这样的研究嗤之以鼻额。毕竟,如果我们询问机器人制造公司,为什么要将他们的机器人设定为白色,他们十有八九会告诉你:因为白色跟各种家庭装饰都很百搭呀!

实际上,Bartneck的文章在投稿期间就收到了不小的阻力。他们的文章被读者反复审视,有些人指责作者在耸人听闻。

那么,这项研究的结论究竟如何得出,对我们又有哪些启发呢?

让我们通过IEEE对Bartneck的一段专访作进一步的了解。

专访内容

《科技纵览》杂志(IEEE Spectrum):你在这项研究中具体在回答什么问题?

Christoph Bartneck:首先,我们想探究人类是否将机器人与种族相关联。其次,如果答案是肯定的,那这种对机器人种族的归类是否影响人类对待这些机器人的行为。更详细地说,我们会让参与者回答一系列问题,包括对某一机器人的种族分类(选项包括“不赋予种族”)另外, 我们也使用了“射手偏见”框架(shooter bias framework)。

在射手偏见研究中,参与者被赋予警察的角色,当面对人们手持枪械或其他友好物体的图像时,他必须决定是否射击。图像仅显示一瞬间,研究中的参与者来不及做出合理的思考,他们必须在不到一秒的时间内采取行动。若参与者在决定开枪时对黑色机器人(对比白色机器人)开枪更加快速,在决定对没有武器的机器人不开枪时对白色机器人(对比黑色机器人)下决定更快速,我们就会认为这位参与者对机器人存在种族偏见。

《科技纵览》杂志(IEEE Spectrum):你们的研究结果如何?

Christoph Bartneck:我们在调查中直接要求人们选择“该机器人是什么种族”时,只有11%的被调查者选择了“不适用”选项。我们的隐性衡量标准证明了人们确实种族化机器人并据此调整他们的行为。我们调查的参与者显示他们存在对机器人的种族偏见。

此外,我们的“射手偏见”研究显示,无论图像中出现的是人类还是机器人,与武装的白人相比,参与者更快地射击武装的黑人;同时更快地避免射击手无寸铁的白人,而不是同样解除武装的黑人。这些发现说明了射手偏见既存在于人类之中,同时也存在于机器人之中。这种偏见明确表现了对黑人的种族歧视,更是将这种歧视自动延伸至种族化为黑人的机器人。

《科技纵览》杂志(IEEE Spectrum):为什么这个主题以前未曾被研究过?你为什么决定对此展开研究?为什么它很重要?

Christoph Bartneck:许多工程师都忙于实现机器人基本功能,如行走与在所处环境中移动。这是他们最为关注的问题,以至于他们没有那么重视研究所产生的社会影响。

大部分时候,机器人的设计是由内而外的,意味着各功能部件先被搭建并测试,最后再添加一个外壳包装。至于这层包装将如何影响人类使用者,或更宽泛地说,机器人整体将如何被其使用者所感知,绝大多数时候只有事后才会被想到。

因此,几乎没有机器人创造者思考过种族歧视问题。多年来,人-机器人交互(HRI)社区的成员们在尝试更深理解人类与机器人是如何交互的。我们试图帮助机器人创造者将机器人设计得与社会更加融合。种族歧视对人类与人类社会整体都正在造成大量伤害。

今天,种族歧视依然真实地存在,黑人平权运动更加证明了这个问题的重要性与紧急性。与此同时,我们将推出社交机器人,目的是与人类互动,融入人类社会。这些机器人将成为未来的护工,教育人员与陪伴者。

在谷歌图片中搜索“类人机器人”,你几乎只会搜到拥有闪亮白色表面或金属外表的机器人图片。现在几乎没有非白人外表的拟人机器人。大多数主流社交机器人研究平台,如Nao,Pepper与PR2,机器人均使用白色材料,并且看起来是白人。

也有一些特例,比如一些由Hiroshi Ishiguro团队设计的机器人——这些机器人的面部以某些特定的日本人为模型,因此它们的种族为亚洲人(如果机器人真的拥有种族属性的话)。另一个特例是Bina48机器人,它被设计为黑人形象。

可以预见到,这种社交机器人种族多元性的匮乏会导致一系列问题以及其他领域中种族多元性的匮乏。我们根据各社会分类下的社会观念导致的刻板印象去评价他人。比如,歧视经常是社会刻板印象的一种体现。如果机器人将被用于教师,好友或护工并且这些角色都只被白人机器人取代,这将会是一个严重问题。

我们希望我们的研究能促使人类进行反思,是什么社会与历史因素导致了来自如此多元化的种族群体的工程师们几乎只设计生产很容易被当做白人的机器人,他们为何尚未意识到这一点。

《科技纵览》杂志(IEEE Spectrum):如果机器人被认为是分种族的,这将对人-机器人交互(HRI)有何影响?

Christoph Bartneck:我们相信我们的发现将会帮助社交机器人设计上的多元化,这样一来这项前景光明的科技不会受到种族偏见的影响。中东样貌的机器人的出现以及日本惯以设计亚洲人样貌的机器人都是这个方向上的重要进步,尤其是因为这些机器人并非被刻意设计成丰富种族多元化的形象,而是机器人设计上的自然产物。

《科技纵览》杂志(IEEE Spectrum):您能否讨论一下该研究的局限性?您将来如何改进该领域的研究?

Christoph Bartneck:不难推测,不同程度的拟人化可能会导致不同的结果。如果几乎难以区分机器人与人类,那么我们期望得到与原始研究相同的结果,而更机械化的机器人可能具有尚未确定的影响。人们也可以思索一下我们使用的种族化方法。

为了最好地复制原始的射手偏见刺激,我们选择使用人工校准让Nao机器人呈现种族化特征,而不是使用Nao默认的白色塑料外观以及与之相对的黑色材料机器人。

值得注意的是,Nao机器人没有穿任何衣服,这与原始研究中的人类不同。另外很奇怪的是,原始研究中图像里的人们没有影子。借助Adobe Photoshop强大的功能,我们能够在Nao机器人背后投射阴影合成更为逼真的图像。未来的研究应该包括拿着枪和其他物体的Nao机器人,并伴有多种姿势。

我们也将对机器人表面颜色添加渐变色,使其包括几种棕色渐变色。此外,我们正在研究机器人的拟人化程度会如何影响对种族的认知。

《科技纵览》杂志(IEEE Spectrum):听说HRI会议接收该论文的过程并不顺利,您能详细说明吗?

Christoph Bartneck:这篇提交给HRI会议的论文经历了空前的审查过程。论文大约有5000个词,但收到的评论就有大约有6000个词。在会议计划委员会开会期间,大家对文章进行了详细的讨论,共有9名评审员被要求对该研究进行评估。

这篇论文最终被有条件地接收,他们分派一个专门的编辑,与我们一起解决审稿人提出的所有问题。这样子,作者和编辑可以尽其所能解决所有争论并找到合适的答案。论文中的方法和统计数据从未被怀疑,大多数评论者着眼于术语和文字表达。

在会议之前,我联系了会议的主持人,并建议在会议上进行小组讨论,以便就该主题进行公开辩论。不过,最初热情的提议最终被拒绝了。接着,我建议在分配给该项研究的演示时段内留出小组讨论的时间。获得初步同意之后,我寻求了两位同意参加的专家,然而会议组织者禁止了这次小组讨论。在演示的前一天,我被要求在没有任何评论或小组讨论的情况下提交论文。

我们试图在会议上就我们论文的结果进行公开讨论,但都遭到了拒绝。我认为这种拒绝公开讨论会阻碍对该领域的进一步研究。那你为什么要让自己暴露在如此严厉的,意识形态驱动的批评当中?我认为我们需要有一种支持和鼓励的文化来研究有争议的话题。

《科技纵览》杂志(IEEE Spectrum):您希望看到这项研究成果如何应用?

Christoph Bartneck:我们希望这项研究鼓励机器人设计师们创造出代表社区多样性的机器人,不是所有的机器人都得是白色的。